-

CutMix: Regularization Strategy to Train Strong Classifierswith Localizable Features논문 Review 2020. 10. 23. 03:26

2019 서울 코엑스에서 열린 ICCV에 발표된 CutMix 논문이다.

네이버 클로바와 연세대학교에서 진행한 연구 논문이다.

이미지 분류를 하던 도중에 알게 된 내용이라 빠르게 읽고 논문 구현을 위한 코드 중심으로 봤다.

Introduction

우리가 어떤 물체를 분류할때 물체의 특징적인 부분만 분류하는 경우가 있다.

CNN 에서 Reginal dropout 전략을 사용하면 네트워크가 일반화 성능을 높여줄 수 있다.

하지만 여기서 문제가 있다.

이미지에서 어떤 부분이 제거될때 이 부분이 모델의 유용한 픽셀을 없애는 경우가 생길 수도 있다.

CNN은 일반적으로 data가 많이 필요하기 때문이다.

이러한 regional dropout 방식의 한계를 극복하고자 cutmix가 제안 되었다.

간단히 말하면 Cutmix는 이미지의 픽셀을 단순히 지우는 것이 아니라 제거된 영역을 다른 이미지로부터 가져온 patch로 적용한다. 추가된 patch의 부분적인 모습만 보고 물체를 추정할 수 있기 때문에 localization 또한 성능이 향상 된다.

일종의 data augmentation 전략이다.

Related Work

Reginal Dropout : Random erasing , Cutout

Random Erasing 방법이다. Cutout가 유사한데 이미지의 부분을 랜덤적으로 자른다음에 radnom values나 ImageNet의 평균 pixel로 대체한다.

Dropblock

기존 방법이 input image에서 실행한거와 달리 dropblock은 featuremap에서 연속적인 region을 drop 시키는 방법이다.

Synthesizing training data

Generating new training samples by Stylizing ImageNet

이 모델은 texture보다 shape에 더 focus 해서 classificication 한다.

Mixup

Mixup은 두개의 sample을 뽑아 linear interpolation 을 통해 학습에 필요한 image와 label을 만든다.

하지만 이 샘플들은 지역적으로 모호하고 자연스럽지 않아서 localization task에서 문제가 있다.

CutMix

Algorithm

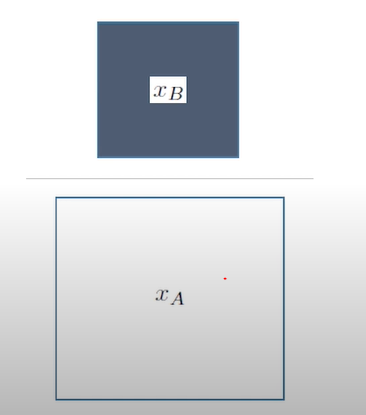

두개의 training sample을 조합해서 새로운 sample을 만들고 training을 진행한다.

binary mask는 오른쪽 부분에서 흰색부분은 1, 짙은 부분은 0을 가진다.

위 그림 즉 원래 본 image에서 cutmix되는 부분 새로운 image가 들어오는 비율이 공식에서 1-λ을 의미한다.

모든 실험에서 알파는 1로 정하면서 모든 실험에서 λ 는 균일분포로부터 샘플을 구한다.

rx,ry,rw,rh 는 bounding box coordinate를 의미한다. 중심의 x,y좌표이다.

W,H는 본 이미지의 가로,세로 길이를 의미한다.

훈련 반복하는 과정에서 Cutmix-ed 된 sample (x,y)는 무작위로 선택된 두개의 training sample으로 결합하여 생성된다.

cutmix는 간단하고 data augmentation 기술을 사용함으로써 computational overhead를 발생시킨다.

Cutmix는 두개의 물체가 각각 부분적인 view만 가지고도 인식 될 수 있게하고 물체의 전체가 classification 단서로 활용 될 수 있게 한다. 이를 증명하기 위해 Class activation mapping을 통해 cutout와 mixup을 비교했다.

Mixup은 모든 픽셀을 다 사용하기 때문에 부자연스러운 이미지가 생겨서 CAM을 보면 이미지의 단서를 찾는데 혼란스러움을 보여준다. Cutout은 덜 특징적인 부분에 focus를 맞춘다.

Cutmix는 두개의 물체를 Localizatoin 한 모습을 볼 수 있다.

CAM(Class Activation Map)

CAM은 물체를 구분할때 어느 영역,부분을 보고 구별했는지를 알 수 있게 해주는 map이다. 고양이와 개가 있으면 해당 부분을 hit map으로 볼 수 있다.

Experiment

Feature와 Cutmix의 결과도 알 수 있다.

조금 더 깊은 네트워크인 ResNet-101과 ResNetxt-101에 대한 결과이다.

CIFA-100에 Cutmix를 적용한 결과이다. 하이퍼파라미터의 값에 따라 결과가 달라짐을 알 수 있다.

CIFA-100에서 layer depth와 Cutmix의 모델을 다양하게 바꿔 실험한 결과이다.

WSOL

먼저 Weak-supervision task란, 시간과 돈이 많이 드는 전체 supervision을 사용하는 대신 (예: segmentation mask) 훨씬 구하기 쉬운 supervision만을 사용해 (예: class label) 비싼 supervision 정보를 얻어내는 task들을 일컫는 말이다.

.

Weakly Supervise Object Localization은 class label만으로 CNN을 training 하여 target objects를 잘 localize하게 하는 것이다.

Cutmix의 좋은 결과를 보여준다.

Transfer Learning

Stronger localizability of the Cutmix pre-trained models가 더 좋은 detection 퍼포먼스를 보인다.

Image Captioning에서도 Cutmix가 뛰어남을 알 수 있다.

Conclusions

Cutmix를 CNN에 사용해 강력한 classification과 localization 능력을 봤다. Cutmix는 구현이 쉽고 computational overhead도 없이 효과적으로 다양한 과제를 할 수 있다.

Image classification

Weakly supervised object localization

Transfer Learning of pretrained models

Robustness and Uncertainty

위와 같이 다양한 분야에서 Cutmix에 우수성을 확인할 수 있었다.

Image classification을 하다가 우연히 알게 되어 빠르게 살펴본 논문이다. 알고리즘도 간단하고 개념도 쉬운 방법인데

상당히 좋은 효과가 있다고 한다. 실제로 내가 oxpord dataset으로 진행한 Image classification에서 Cutmix를 사용하면

1%정도의 accuarcy가 올라갔다. data augmentation을 할때 알고있으면 좋은 기법이라고 생각한다.

참고자료 : http://www.laonpeople.com/

'논문 Review' 카테고리의 다른 글

Knowledge Distillation for Multi-task Learning (0) 2022.02.06 Generative Adversarial NetS (GAN) (0) 2020.11.23 Image Super-Resolution Using Deep Convolutional Networks (0) 2020.10.18 Bag of Tricks for Image Classification with Convolutional Neural Networks (0) 2020.10.02 Batch Normalization (0) 2020.08.16